Olá! Aqui é Geovana Leal, engenheira de dados da e-Core, e estou entusiasmada para compartilhar minha experiência no AWS Summit 2023. Participar de eventos como esse é sempre uma oportunidade incrível para trocar experiências com outros profissionais da área e mergulhar em palestras enriquecedoras.

Uma das palestras que me deixou particularmente intrigada foi intitulada “Como o iFood gerencia seus pipelines de ML com o Amazon SageMaker”. Como usuária assídua do aplicativo, a perspectiva de entender como eles moldam as recomendações para nós, clientes, me chamou a atenção de imediato.

Para dar um contexto, o Amazon SageMaker é um serviço completamente gerenciado pela AWS, projetado para simplificar a preparação, construção, treinamento e implementação de modelos de machine learning de alta qualidade. Ele reúne um conjunto abrangente de recursos específicos para ML, compatíveis com diversos frameworks e linguagens de programação.

A palestra foi iniciada por Carolina Carneiro, Arquiteta de Soluções da AWS, que questionou: “O que fazer quando o modelo não está mais performando como deveria?”. Uma pergunta intrigante que nos leva a refletir sobre a necessidade de monitorar e aprimorar continuamente nossos modelos após a implementação. Carolina enfatizou que a jornada de um modelo não acaba quando ele é colocado em produção – o monitoramento constante, retreinamento e avaliação dos dados são vitais para garantir seu desempenho ao longo do tempo.

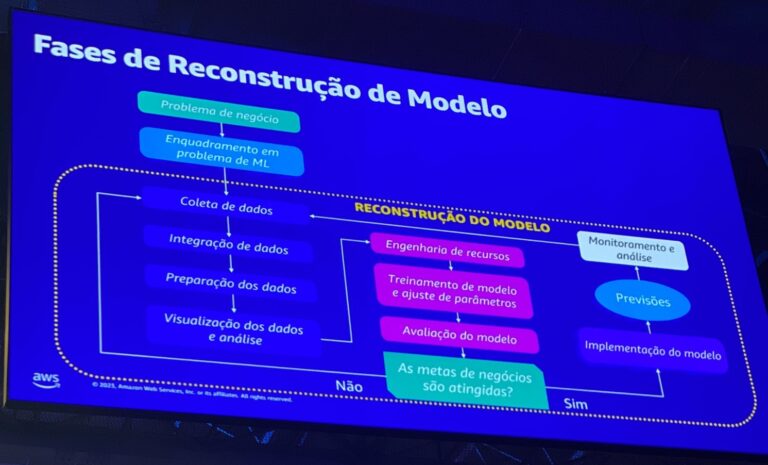

Uma das partes mais interessantes da palestra foi a exploração das etapas de reconstrução de um modelo conforme a figura a seguir (um pouco torta, pois foi uma foto tirada rapidinha para mostrar pra vocês).

A reconstrução começa com a definição clara de um problema de negócio e a categorização dos desafios. A coleta de dados precisa ser minuciosa, com foco nas características relevantes para treinar o modelo. A escolha do algoritmo é crucial, assim como a adaptação aos fluxos de trabalho automatizados para maior eficiência e escalabilidade.

Foi apresentado o conceito de MLOps – um conjunto de práticas operacionais destinadas a automatizar e padronizar o pipeline de ML. A adoção do MLOps pelo Amazon SageMaker introduziu ferramentas e integrações nativas com outros serviços da AWS, possibilitando um fluxo completo de CI/CD, automação de fluxos de trabalho de ML, observabilidade, explicabilidade e um monitoramento aprofundado. A clareza e rastreabilidade do código em cada estágio do pipeline de ML proporcionam um ambiente desacoplado e de alto desempenho.

Na sequência, Daniel Vieira, Gerente de Engenharia de ML do iFood, compartilhou insights sobre o ML Go!, uma plataforma de pipelines de ML criada pelo próprio iFood. Com mais de 120 modelos em produção, criados por 17 times distintos e que levam a 10 bilhões de recomendações, a empresa enfrentava desafios como sobrecarga operacional manual, baixa reutilização de etapas no pipeline e dependência excessiva de equipes.

O ML Go! foi desenvolvido para automatizar todo o ciclo de vida de um modelo, integrar desenvolvimento com operações e fornecer capacidades fundamentais para a gestão e manutenção de sistemas de ML. A plataforma permite a definição e análise de modelos, retreinamento, gatilhos, métricas e entradas de eventos.

Essa automação libera equipes para se concentrarem em outras tarefas, reduzindo falhas e permitindo maior agilidade. A governança por equipe evita alterações não autorizadas no pipeline, e a plataforma ajuda a avaliar quando é necessário criar ou reforçar um modelo.

O ML Go! apresenta recursos como entrega de artefatos de código do ML, construção de pipelines SageMaker, automação de acionamentos personalizados, interface declarativa e validação automática de recursos. A plataforma é baseada em serviços como SageMaker pipeline, SageMaker Studio e outros componentes da AWS.

A palestra concluiu com importantes lições:

- Descentralize e integre: Evite gargalos e permita que todos tenham autonomia para implementar modelos;

- Tenha uma base sólida: Pense nas bases essenciais para todos os sistemas de ML desde o início;

- Reduza a complexidade: Ofereça uma experiência agradável para todas as partes envolvidas, aumentando a eficiência e a entrega de valor.

Em resumo, ficou evidente que a criação de processos bem definidos é fundamental para agilizar a entrega de soluções aos clientes. Processos claros reduzem a dependência de indivíduos específicos, permitindo que várias pessoas executem tarefas e criem modelos com eficiência.

Além disso, a importância do monitoramento constante foi destacada de maneira marcante. Após a implementação de um modelo, a frase “não podemos ir para casa dormir” ressoa fortemente. Devemos regularmente validar se o modelo ainda está agregando valor, evitando custos desnecessários caso o modelo não esteja mais alinhado com os objetivos.

Práticas como as que foram apresentadas pelo iFood não apenas aprimoram nossas operações internas, mas também ajudam a entregar soluções mais eficazes e valiosas aos nossos clientes. Estou ansiosa para aplicar essas lições e ver os resultados tangíveis que elas podem trazer para nossa equipe e para aqueles a quem servimos.

Agradeço ao AWS Summit por proporcionar uma visão tão inspiradora do mundo do ML e da automação.

Até a próxima!